Wie AI im Projektmanagement einsetzen?

Alles, was Sie über AI wissen müssen, in nur 15 Minuten. Reden wir zunächst darüber, was AI ist und was nicht. Dann sehen wir uns an, wie wir AI-Tools einsetzen können, um mehr als nur die alltägliche Projektarbeit zu erleichtern. Abschließend werden wir uns noch mit der Ethik von AI befassen und die Herausforderungen beleuchten, die sich bei der Nutzung von AI ergeben können.

Einführung in AI

Beginnen wir mit ein wenig Theorie. Im Allgemeinen unterteilen wir AI in "Narrow" und "General". Narrow AI ist in der Lage, eine eng umrissene Aufgabe oder eine Reihe von Aufgaben perfekt auszuführen. Diese Art von Intelligenz begleitet uns schon seit Jahren, z. B. FaceID, Spamfilter und viele andere.

Allgemeine AI hingegen lässt Anzeichen von intelligentem Verhalten bei einer Vielzahl von kognitiven Aufgaben erkennen. Eine solche AI gibt es noch nicht und es ist unwahrscheinlich, dass es sie im nächsten Jahrzehnt geben wird.

Aber warum reden wir in letzter Zeit so viel über AI, wenn es sie doch schon seit Jahren gibt? Und es frühestens in zehn Jahren eine richtige AI geben wird? In erster Linie, weil Tools wie Midjourney, Stability AI, ChatGPT oder Github Compilot generativ sind, d. h. sie erzeugen neue Inhalte auf der Grundlage von Daten.

Und warum fasziniert und erschreckt uns das gleichzeitig so sehr? In erster Linie, weil wir Kreativität für eine rein menschliche Eigenschaft halten.

ChatGPT kann man nicht trauen

Lassen Sie uns mit ChatGPT beginnen. Die New York Times bat ChatGPT (Version 3 ☝️), einen Aufsatz über Antoine De Machelet, einen belgischen Chemiker, zu schreiben. Sie begann sofort mit dem Schreiben eines Aufsatzes, der jedoch frei erfunden war. Das sollte niemanden überraschen - ChatGPT ist, wie der Name schon sagt, nur ein Sprachmodell (GPT steht für generative pre-trained transformer).

Das Hauptproblem besteht darin, dass ChatGPT eine Narrow AI ist, die sich auf eine Reihe spezifischer Aufgaben konzentriert - das Verstehen und Erzeugen von Text. Sie sagt nichts darüber aus, ob der generierte Text korrekt ist.

AI ≠ ChatGPT

Es gibt wirklich eine ganze Reihe von AI-Tools. In letzter Zeit wird man damit auf LinkedIn geradezu zugeschüttet. Und wir alle nutzen sicherlich täglich Dutzende davon, bewusst oder unbewusst. Ich zum Beispiel arbeite jeden Tag mit Google Sheets. Ich exportiere dort etwas für Kunden oder verarbeite Daten für eine Entscheidung.

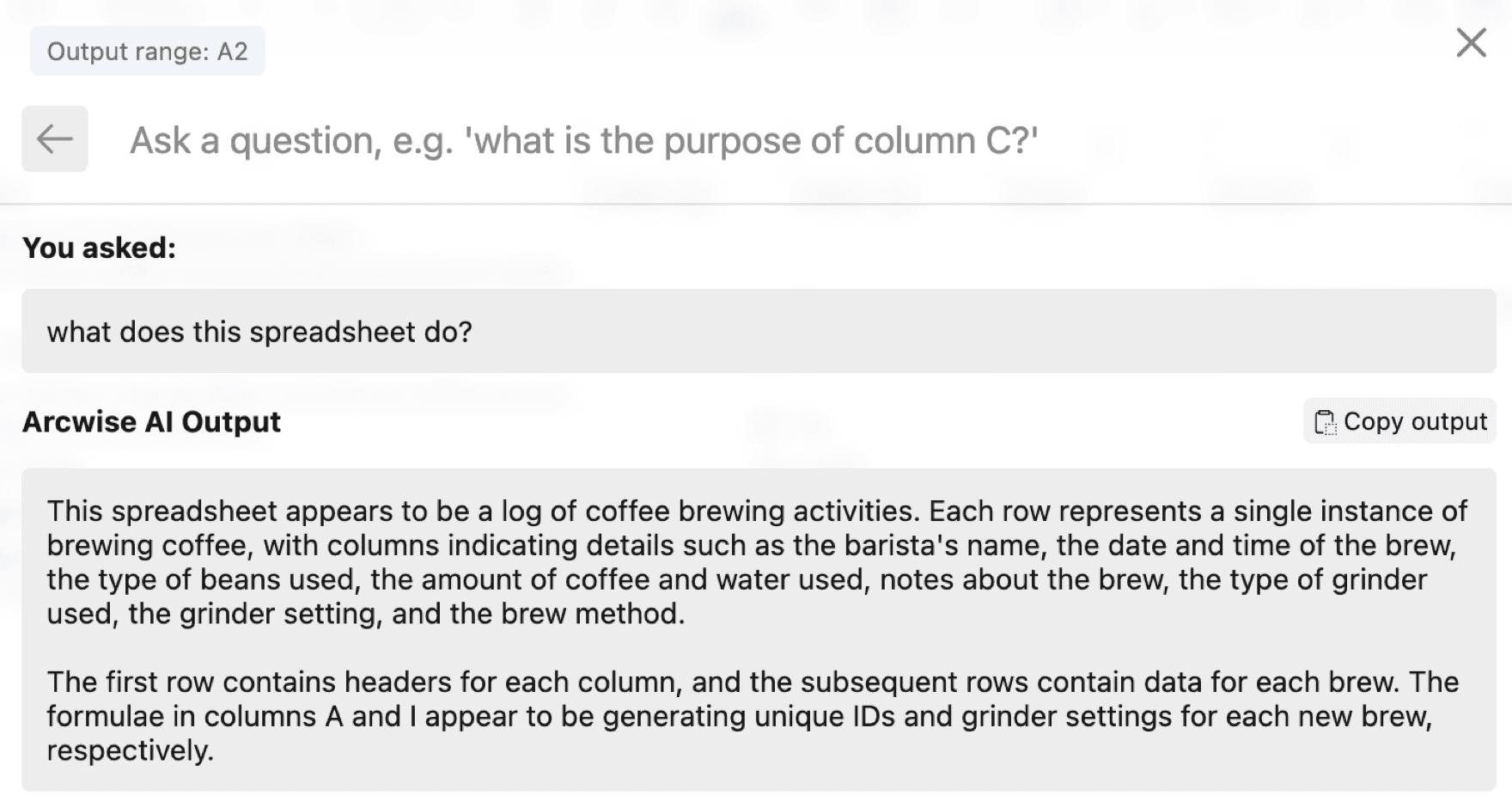

Arcwise beispielsweise ist ein Add-on zu Google Sheets, mit dem ich unter anderem erklären kann, wozu das jeweilige Sheet dient, oder auch Daten aus einem geöffneten Tab bearbeiten, vereinheitlichen oder scrapen kann.

Ich frage einfach "Was macht dieses Sheet?" und erhalte eine einfache Antwort, in der die wichtigsten Funktionen erklärt werden.

Ich bin jeden Tag in mehreren Meetings. Normalerweise gehört es zu meinen Aufgaben, wichtige Punkte aufzuschreiben, Aufgaben zu verteilen und den Kontext des Projekts zu gewährleisten.

Otter.ai (aber auch andere Tools wie MeetGeek oder Firefly) kann an einem Meeting teilnehmen, es automatisch aufzeichnen, ein Transkript erstellen und dann eine Zusammenfassung des Meetings verfassen. Darüber hinaus können Sie die Transkripte aller Besprechungen durchsuchen.

Eines Tages wird es ein komplettes AI-Archiv geben, das Sie mit Sitzungsprotokollen, Projektdokumenten oder Tickets verknüpfen und problemlos durchsuchen können.

Die Ethik der AI

Künstliche Intelligenz ist relativ neu in unserem Leben und nicht wirklich reguliert. Es ist wichtig, die Risiken zu kennen, die AI mit sich bringt und zu wissen, wie man ethisch damit umgeht.

Um auf den NYT-Fall mit dem belgischen Chemiker zurückzukommen: Warum hat ChatGPT so reagiert? Warum hat sie alle Daten komplett erfunden? Und beunruhigt uns das? Schon ein wenig.

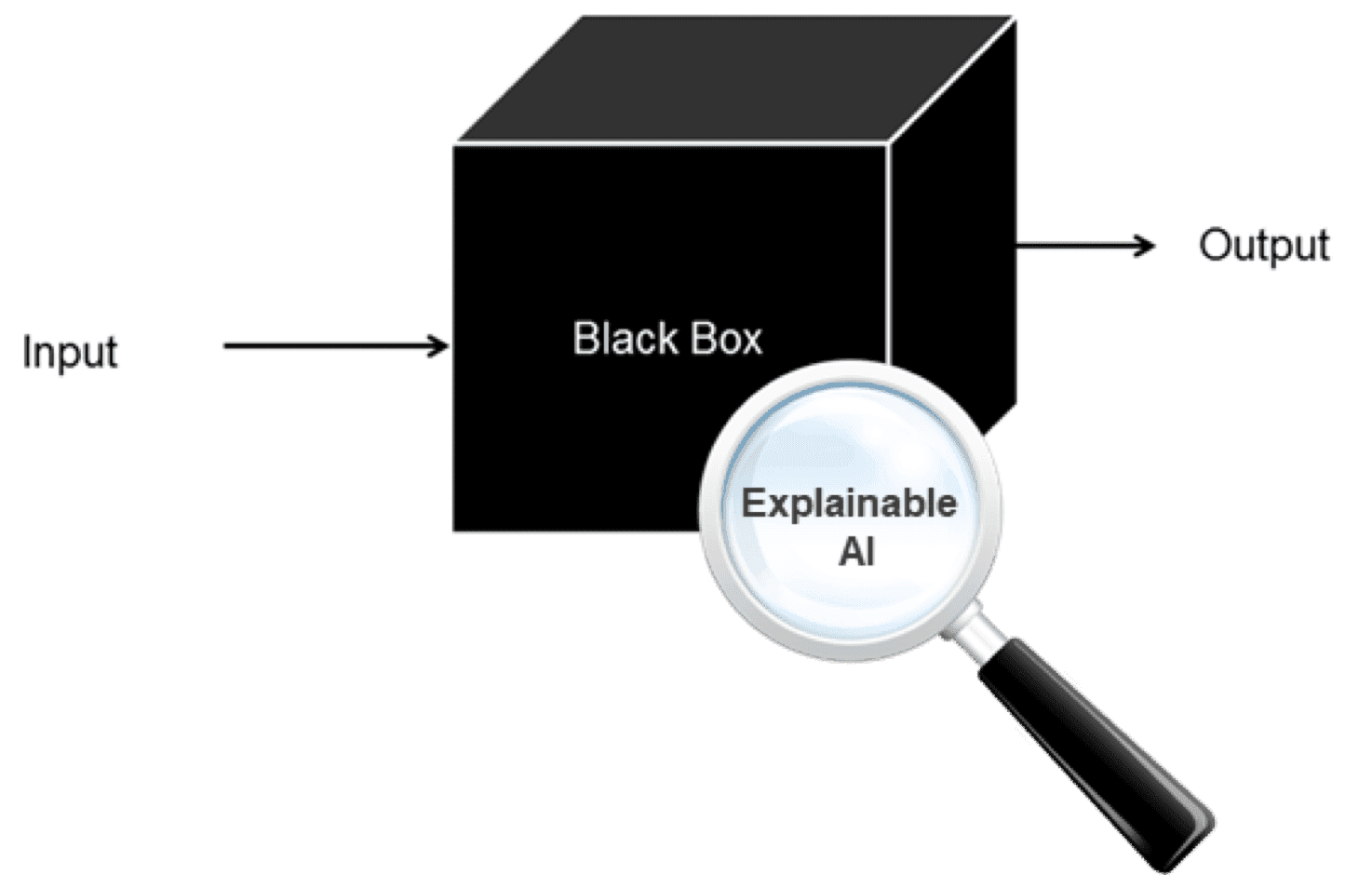

Vor allem ist es aber eine lustige Geschichte. Was aber, wenn wir wissen wollen, warum das Decision Support System eine bestimmte Entscheidung empfohlen hat? Oder warum unser Applicant Tracking System empfiehlt, einen bestimmten Bewerber abzulehnen? In dem Fall würden wir auch den HR-Experten fragen, warum.

Dieses Problem ist als Blackbox-Problem bekannt. Niemand, oft nicht einmal die Entwickler, hat eine Ahnung, warum die AI genau so reagiert hat. Die Lösung für das Blackbox-Problem heißt Explainable AI (XAI). Weil wir oft nicht nur die Antwort wissen wollen, sondern auch, warum die AI genau so gehandelt hat.

Das zweite Problem, über das wir hier sprechen, heißt Garbage in, Garbage out. Dies ist ein ziemlich bekanntes Prinzip der Computerwissenschaft. Allerdings bedeutet "Garbage in" nicht, dass man es in ChatGPT eingibt und die Antwort dann "Garbage out" wegschmeißt.

Garbage in sind Trainingsdaten für maschinelle Lernalgorithmen. Wenn die Eingabedaten nicht von ausreichender Qualität sind, werden auch die Ergebnisse nicht zufriedenstellend sein. Schlechte Daten können frühere Fehlentscheidungen oder unsere eigene Voreingenommenheit widerspiegeln. Möglicherweise sind Frauen oder Minderheiten unterrepräsentiert. Diese Probleme werden durch künstliche Intelligenz nur noch verstärkt.

Was kann passieren, wenn ich den Lerndaten nicht genug Aufmerksamkeit schenke? Zum Beispiel das:

- iPhone X Rassismus-Streit: Apples Face ID kann nicht zwischen chinesischen Nutzern unterscheiden

- Selbstfahrende Autos fahren, laut einer Studie, eher Schwarze an

- Das selbstfahrende Auto von Uber wusste nicht, dass Fußgänger manchmal bei Rot über die Straße gehen

AI im Projektmanagement

Künstliche Intelligenz kann uns eine Menge Arbeit abnehmen. Und sie kann uns vor allem die Arbeit ersparen, die wir nicht gern machen. Aber wir müssen die Ergebnisse kritisch betrachten und uns der Grenzen bewusst sein, die AI (zumindest im Moment) hat.

Denn sie ist auf eine Art dumm, die wir derzeit noch nicht durchschauen. Ich freue mich, wenn Sie das auch so sehen.